GPT-4o医学知识覆盖率仅55%?大模型医疗能力“体检报告”来了

在医疗领域,大语言模型(LLM)的潜力令人振奋,但其知识储备是否足够可靠?腾讯优图实验室天衍研究中心的最新研究给出了答案。

他们提出的MedKGEval框架,首次通过医疗知识图谱(KG)的多层级评估,系统揭示了GPT-4o等主流模型的医学知识覆盖度。

该研究已被会议Web4Good Track录用为口头报告(oral)。目前,WWW PG电子官方平台入口2025正在悉尼举行,会议时间从4月28日持续至5月2日。

大语言模型(LLM)在医疗领域的快速发展凸显了其知识存储与处理的潜力,但其临床部署前的可靠性验证亟需更系统化的评估框架。

当前主流的Prompt-CBLUE、Medbench和MedJourney等评估体系虽通过医学问答基准测试LLM的任务执行能力,却存在三个明显的局限:

2)任务导向的设计聚焦疾病预测、用药咨询等单一场景,难以量化模型内在医学知识储量;

为解决这些问题,本文提出基于医疗知识图谱(KG)的多层级评估框架MedKGEval。

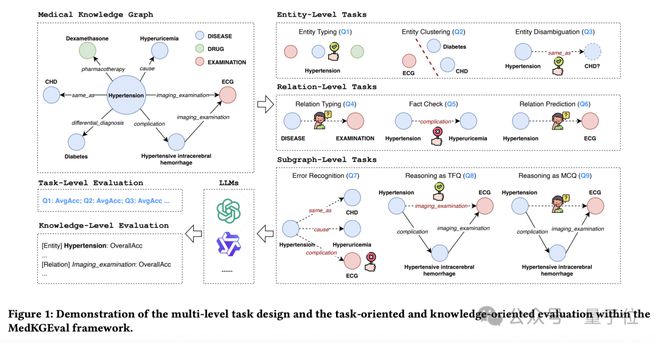

医疗KG通过结构化存储复杂实体关系网络,为评估提供天然基准。框架创新性地设计三级评估体系:实体层评估医学概念理解,关系层检验医学关联区分能力,子图层验证结构化推理水平。

通过真伪判断和多选题形式,同时实现任务导向(task-oriented)的粗粒度性能评估与知识导向(knowledge-oriented)的细粒度三重覆盖度测量(实体/关系/知识三元组)。

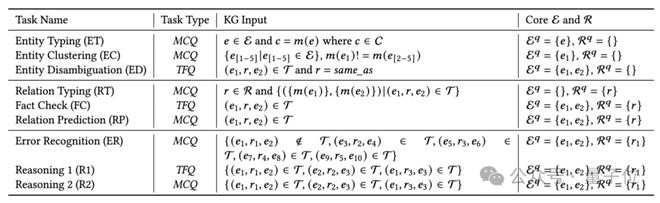

在MedKGEval中研究团队设计了多层级的任务体系,其中包含3个层级的9项核心任务,通过真伪判断(TFQ)与多选题(MCQ)任务形式,实现任务导向与知识导向的双重评测。

随着利用的KG信息增多,任务难度也在逐渐升高,这样阶梯式、多层级的评估更有利用全面了解LLMs的性能。

在每项任务中均配备评估核心实体/关系映射(如上图 core E and R),实现细粒度知识覆盖分析:

MedKGEval选用中文医疗领域主流知识图谱CPubMedKG和CMeKG作为基准,经下采样构建实验数据集。

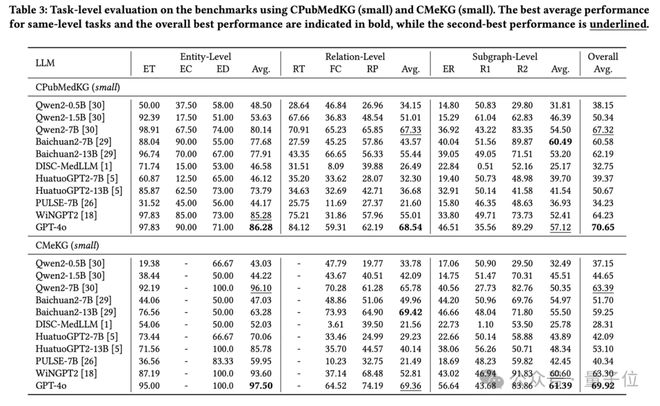

下表展示了11个LLM的任务导向评估结果,可以看到:GPT-4o以70.65%平均准确率领先;同架构LLM参数量翻倍带来3-5%准确率提升;大多LLM在实体层面任务上表现优于关系和子图层面;通用模型性能超越医疗垂类模型(归因分析:垂类模型微调数据侧重具体任务(如用药咨询、医患对话摘要),导致医学知识广度受限)。

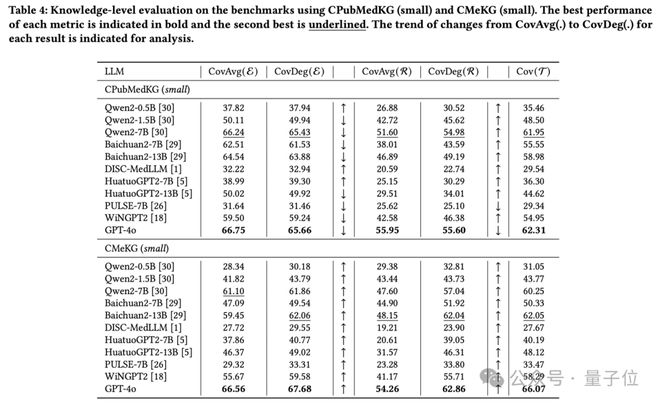

下表展示了11个LLM的知识导向评估结果,可以看到:GPT-4o在CPubMedKG (small)上覆盖了65.66%的实体、55.60%的关系、62.31%的三元组;更大的参数量通常会带来更高的知识覆盖度;CovAvg 和 CovDeg 的对比体现出了LLM对高关联度实体(如糖尿病)和高频关系(如鉴别诊断)的偏好性:CovAvg CovDeg 说明 LLM 在高关联度实体的上表现更好、反之说明 LLM 在低关联度实体上表现更好。

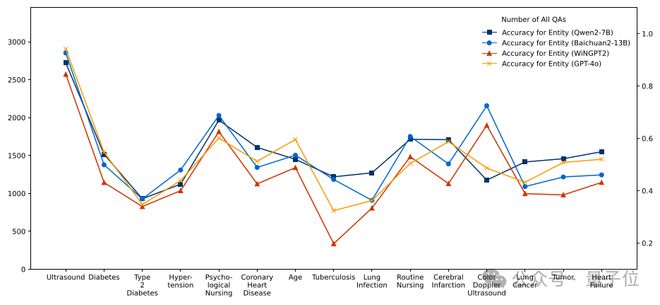

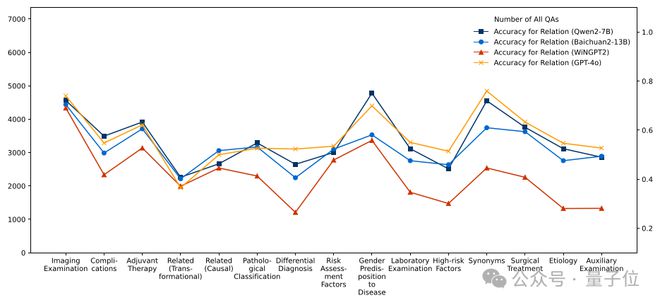

接下来,研究团队使用MedKGEval评估框架对四个示例LLM在关联度最高的15个实体和最高频的15个关系上的知识覆盖情况进行分析。

分析结果表明,MedKGEval能有效定位LLM在特定医学知识领域的认知缺陷。

这些发现对模型优化具有重要指导价值:如上图所示,WiNGPT在“肺结核”实体相关问答中表现欠佳、Baichuan2-13B在“相关(转换)”关系中存在明显短板。

因此,在下轮微调中建PG电子官方平台入口议针对性补充结核病诊疗指南和病理转化机制相关数据,通过基于知识缺陷诊断的定向增强策略,可显著提升医疗领域LLM的整体性能。

本文提出的MedKGEval框架通过医疗KG视角,构建了评估LLM医学知识覆盖度的多维度体系。

该框架在实体、关系和子图三个层级展开评估,系统揭示了当前大语言模型在医学知识存储与推理能力方面的优势与局限。

研究团队提出的的任务导向与知识导向双轨评估机制,不仅能够精准定位模型的知识薄弱环节,更为提升医疗领域LLM的可靠性和临床应用价值提供了量化依据。

特别声明:以上内容(如有图片或视频亦包括在内)为自媒体平台“网易号”用户上传并发布,本平台仅提供信息存储服务。

巴克利:如果湖人输掉与森林狼的系列赛,我不想再听到詹姆斯是历史前五球员的说法

A股公司董事长宣布自愿放弃领薪,去年年薪超72万元!还有多名高管自愿降薪

说出你的金点子!北京市中小学生科学建议活动即将开启申报 | 附参考议题

《编码物候》展览开幕 北京时代美术馆以科学艺术解读数字与生物交织的宇宙节律

《明末:渊虚之羽》PC 配置要求公开,推荐 RTX 3070 及以上显卡